Google führt visuelle und gesprächsbasierte KI-Suche mit Gemini 2.5 ein

Google startet eine neue Generation seiner Suchtechnologie: Der aktualisierte AI Mode in Google Search bringt visuelle Ergebnisse, natürliche Spracheingaben und eine multimodale Interaktion zusammen. Mit der Integration des Gemini 2.5-Modells verändert sich die Art, wie Nutzer mit der Suchmaschine kommunizieren – weg von reinen Stichwortanfragen, hin zu intuitiven, kontextbasierten Gesprächen.

Vom Keyword zur Konversation: So funktioniert das neue Sucherlebnis

Die klassische Keyword-Suche stößt oft an ihre Grenzen – insbesondere, wenn Nutzer eine vage Idee oder ein visuelles Konzept im Kopf haben. Wer bisher nach etwas wie „minimalistischem Schlafzimmerdesign mit dunklen Akzenten“ suchte, erhielt meist unzusammenhängende Ergebnisse.

Googles neuer AI Mode bricht mit diesem Muster. Statt nur Listen mit Textlinks zu liefern, präsentiert die KI nun visuelle Übersichten mit relevanten Bildern, Designs und Konzepten. Nutzer können ihre Anfrage anschließend in einem natürlichen Dialog weiterentwickeln. Eine Eingabe wie „Zeig mir Varianten mit kräftigen Farben“ passt die Resultate sofort an – ähnlich wie in einem Gespräch mit einem persönlichen Berater.

Auch interessant: Google macht Chrome zum KI-Assistenten: Gemini, AI Mode & mehr Sicherheit

Visuelle Intelligenz trifft Sprache: Suche beginnt jetzt auch mit Bildern

Das neue System unterstützt nicht nur Textbefehle, sondern ist vollständig multimodal ausgelegt.

Nutzer können:

- ein Foto hochladen,

- ein Bild mit der Kamera aufnehmen oder

- eine gesprochene Beschreibung verwenden.

Die KI interpretiert diese Inputs kombiniert mit der Anfrage, erkennt feine visuelle Details und liefert präzise, inspirierende Ergebnisse – weit über einfache Objekterkennung hinaus. Das Ziel: eine Suche, die Ideen visuell greifbar macht.

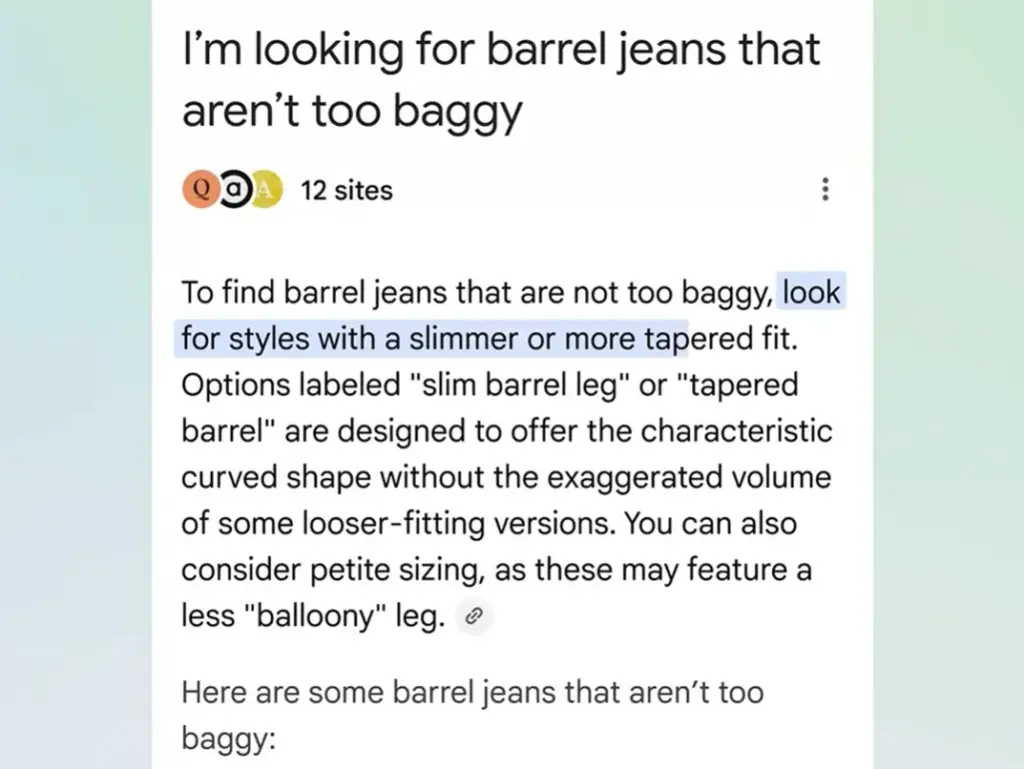

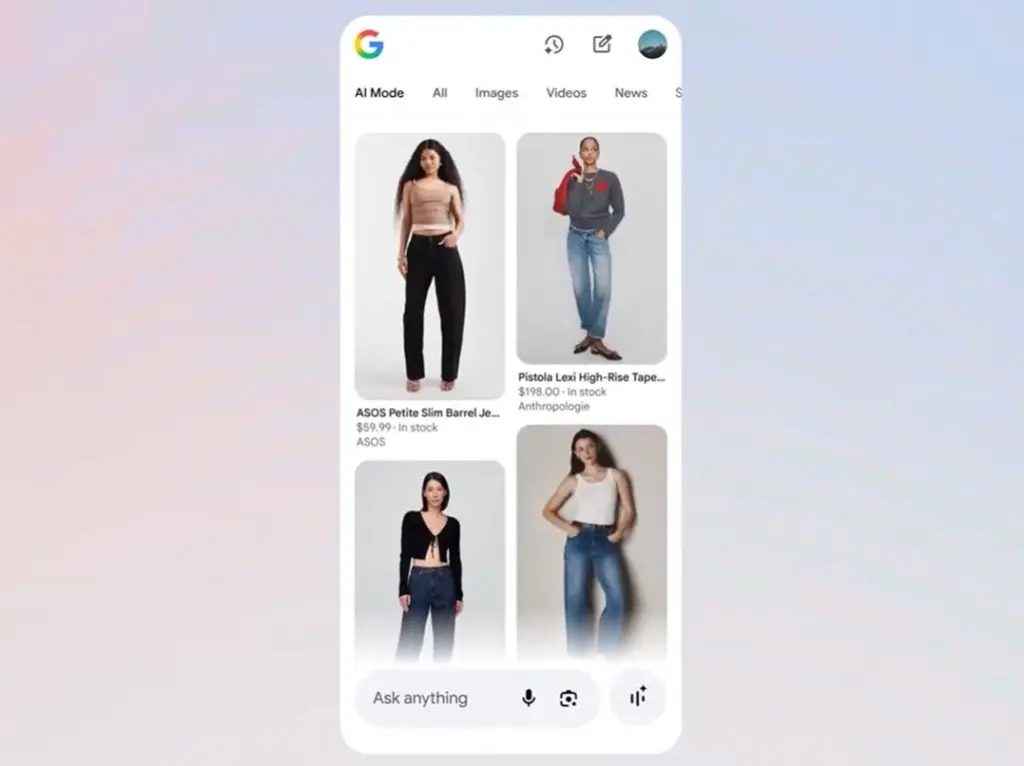

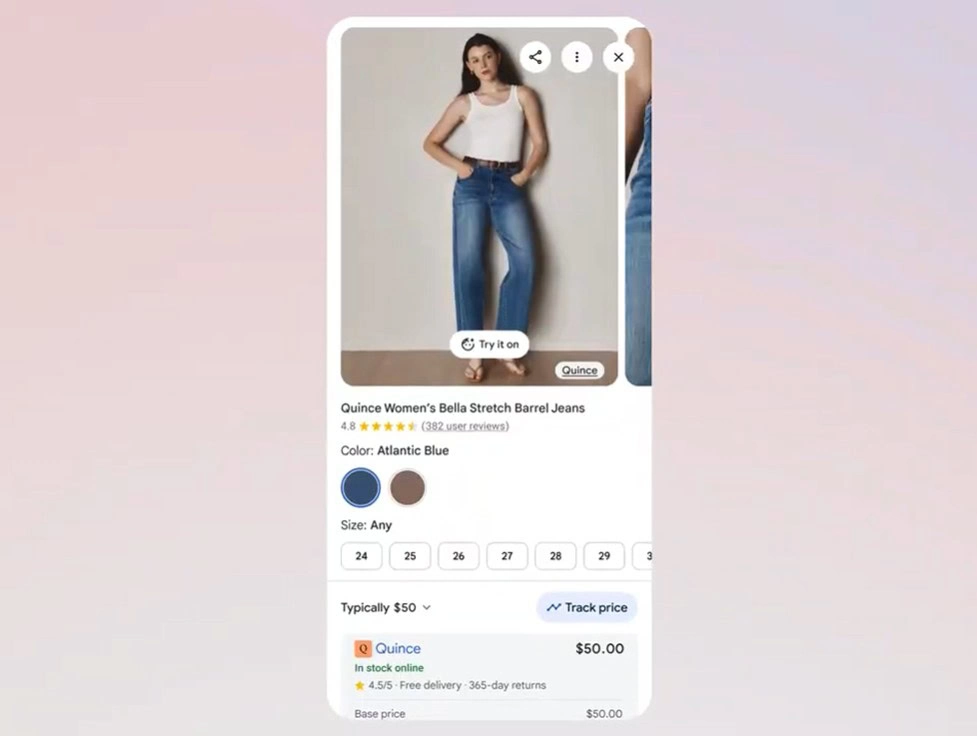

Intuitives Einkaufen durch dialogbasierte Produktsuche

Auch beim Online-Shopping bringt das Update spürbare Verbesserungen. Statt sich durch Kategorien und Filter zu klicken, können Nutzer ihre Wünsche direkt beschreiben – fast so, als sprächen sie mit einem Verkäufer.

Beispiel:

„Zeig mir Jeans, die locker sitzen, aber nicht zu weit sind.“

Die KI versteht die Beschreibung, filtert passende Produkte und präsentiert eine kuratierte Auswahl. Weitere Anpassungen wie „etwas kürzer bitte“ werden sofort berücksichtigt.

Alle Ergebnisse stammen aus Googles Shopping Graph, einem dynamischen Verzeichnis mit über 50 Milliarden Produkten, das kontinuierlich aktualisiert wird. Die angezeigten Artikel sind also verfügbar und führen direkt zu seriösen Händlern.

Neue Technik: „Visual Search Fan-Out“ analysiert Bilder im Detail

Das Herzstück der Neuerungen ist ein Prozess, den Google „Visual Search Fan-Out“ nennt. Dabei werden visuelle Informationen mit den Sprachfähigkeiten von Gemini 2.5 verknüpft.

Die KI analysiert nicht nur das Hauptmotiv eines Bildes, sondern erfasst auch Kontext, Farben, Muster und Stimmungen. Durch mehrere Hintergrundabfragen entsteht ein tiefes Verständnis der gesamten visuellen Szene – was wiederum präzisere, inspirierende Ergebnisse ermöglicht.

Start in den USA: Rollout in weiteren Regionen geplant

Zunächst ist das neue Sucherlebnis in englischer Sprache in den USA verfügbar. Nutzer erhalten dort bereits Zugang zur visuellen und konversationellen Suche. Google plant eine schrittweise Erweiterung auf weitere Länder und Sprachen, um die neue Technologie weltweit verfügbar zu machen.

Googles Suche wird zum visuellen Gesprächspartner

Mit Gemini 2.5 hebt Google die Websuche auf ein neues Niveau. Der AI Mode verwandelt die bisher textbasierte Suche in ein visuelles, intuitives und dialogorientiertes Erlebnis.

Anstatt nach den richtigen Stichwörtern zu suchen, können Nutzer künftig einfach ihre Vorstellungen beschreiben – die KI versteht den Kontext, liefert inspirierende Bilder und unterstützt präzise Kaufentscheidungen.

Die Zukunft der Suche ist nicht mehr nur textbasiert – sie ist visuell, multimodal und menschlich.

Quelle: Google